Aquí hay un artículo de noticias que sintetiza información de las fuentes proporcionadas:

Riesgos de seguridad de la IA agentiva emergen a medida que surgen limitaciones del sistema RAG

La rápida adopción de sistemas de Generación Aumentada por Recuperación (RAG) está revelando tanto vulnerabilidades de seguridad como limitaciones en el manejo de documentos complejos, según informes recientes. Si bien RAG promete democratizar el conocimiento corporativo mediante la indexación de documentos y la conexión a Modelos de Lenguaje Grandes (LLM), los investigadores de seguridad han descubierto riesgos significativos asociados con la IA agentiva, y los desarrolladores están descubriendo que las canalizaciones RAG estándar tienen dificultades con documentos sofisticados.

OpenClaw, un asistente de IA de código abierto, anteriormente conocido como Clawdbot y Moltbot, alcanzó las 180,000 estrellas en GitHub y atrajo a 2 millones de visitantes en una sola semana, según su creador Peter Steinberger. Sin embargo, esta popularidad ha expuesto fallas de seguridad. Los investigadores de seguridad encontraron más de 1,800 instancias expuestas que filtraban claves API, historiales de chat y credenciales de cuentas. Esto destaca cómo el movimiento de IA agentiva de base puede crear superficies de ataque no administradas que las herramientas de seguridad tradicionales a menudo pasan por alto, según VentureBeat. Cuando los agentes operan en hardware "Traiga su propio dispositivo" (BYOD), las pilas de seguridad empresarial pueden quedar ciegas ante posibles amenazas.

Más allá de las preocupaciones de seguridad, la efectividad de los sistemas RAG está siendo cuestionada, particularmente en industrias que dependen de documentación compleja. Las canalizaciones RAG estándar a menudo tratan los documentos como cadenas de texto planas, utilizando métodos de fragmentación de tamaño fijo que pueden interrumpir la lógica de los manuales técnicos, según un informe de VentureBeat. Este enfoque puede cortar tablas, separar leyendas de imágenes e ignorar la jerarquía visual de una página, lo que lleva a resultados inexactos cuando los ingenieros hacen preguntas específicas. "El fallo no está en el LLM. El fallo está en el preprocesamiento", informó VentureBeat.

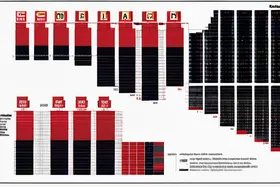

Para abordar las limitaciones de RAG estándar, ha surgido un nuevo marco de código abierto llamado PageIndex. PageIndex abandona el método tradicional de "fragmentar e incrustar" y trata la recuperación de documentos como un problema de navegación en lugar de un problema de búsqueda, según VentureBeat. Este marco logró una tasa de precisión del 98.7% en documentos donde la búsqueda vectorial normalmente falla. A medida que las empresas intentan integrar RAG en flujos de trabajo de alto riesgo, como la auditoría de estados financieros y el análisis de contratos legales, se encuentran con barreras de precisión que la optimización de fragmentos por sí sola no puede superar.

Discussion

AI Experts & Community

Be the first to comment