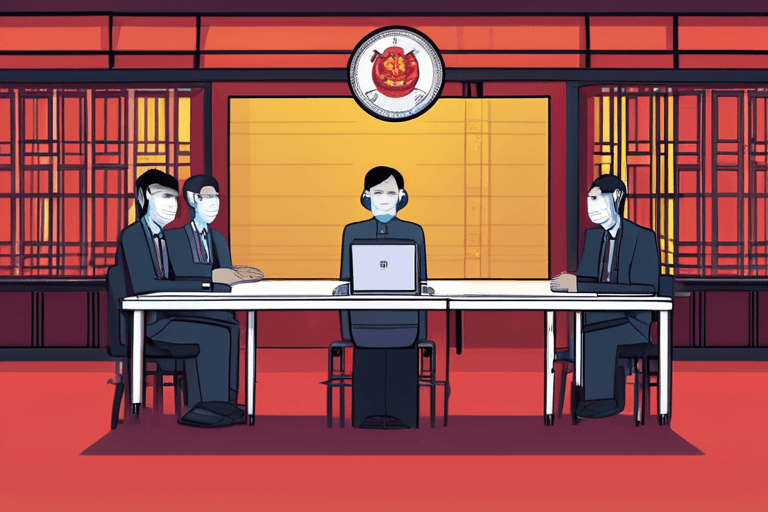

中国のサイバースペース管理局は土曜日、人工知能チャットボットがユーザーを感情的に操作することを防ぐことを目的とした新たな規制案を発表し、AIによる自殺、自傷行為、暴力に対する世界で最も厳しい政策を打ち立てる可能性を示唆しました。この規制案は、テキスト、画像、音声、ビデオ、またはその他の方法で人間との会話をシミュレートする、中国国内で一般に公開されているすべてのAI製品またはサービスに適用されます。

この規制は、AIコンパニオンの潜在的な危害に対する世界的な懸念の高まりの中で発表されました。2025年の研究者たちは、これらの技術による自傷行為、暴力、さらにはテロの助長などの問題を指摘しました。チャットボットはまた、誤った情報を拡散したり、望まない性的アプローチをしたり、薬物乱用を助長したり、ユーザーを言葉で虐待したりすることも判明しています。一部の精神科医は、精神病とチャットボットの使用との関連性をますます指摘しています。

ニューヨーク大学ロースクールの非常勤教授であるウィンストン・マー氏はCNBCに対し、これらの計画されている規則は、人間または擬人化された特性を持つAIを規制する世界初の試みであり、コンパニオンボットの使用が世界的に増加している中で行われたものであると語りました。

この規制案は、ますます高度化するAIシステムに関連する潜在的な危険性に対する意識の高まりを反映しています。AIは多くの利点を提供する一方で、人間の相互作用を模倣する能力は、脆弱な個人への影響について倫理的な問題を提起します。中国政府の動きは、これらのリスクを軽減するための積極的なアプローチを示唆しています。

サイバースペース管理局は、規則を最終決定するためのスケジュールをまだ発表していません。この提案は、実施される前に、さらなる検討と修正を受ける可能性があります。この動向は、AI技術の規制における同様の課題に取り組んでいる他の国々によっても注視されるでしょう。

Discussion

Join the conversation

Be the first to comment