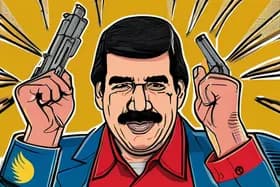

La difusión de estas imágenes generadas por IA coincidió con videos y fotos reales de aviones estadounidenses y explosiones que circulaban en línea, difuminando aún más las líneas entre la realidad y la fabricación. Este incidente subraya el potencial de la inteligencia artificial para ser utilizada en la difusión de desinformación y la manipulación de la opinión pública, particularmente en tiempos de crisis. Los expertos señalan que la velocidad y la escala a la que se propagaron estas imágenes se vieron facilitadas por la creciente sofisticación y accesibilidad de las herramientas de generación de imágenes por IA.

Las Redes Generativas Antagónicas (GAN, por sus siglas en inglés), un tipo de algoritmo de IA, se utilizan a menudo para crear estas imágenes hiperrealistas. Las GAN funcionan enfrentando dos redes neuronales entre sí: un generador, que crea las imágenes, y un discriminador, que intenta distinguir entre imágenes reales y falsas. A través de este proceso iterativo, el generador aprende a crear imágenes cada vez más realistas que pueden ser difíciles de detectar como sintéticas. El incidente que involucra las imágenes de Maduro demuestra cómo estas tecnologías pueden ser utilizadas como armas para difundir narrativas falsas.

"La facilidad con la que se pueden crear y difundir estas imágenes generadas por IA es alarmante", afirmó la Dra. Maya Thompson, profesora de estudios de medios en la Universidad de California, Berkeley. "Cada vez es más difícil para la persona promedio discernir qué es real y qué no, lo que tiene serias implicaciones para nuestra comprensión de los acontecimientos actuales y nuestra confianza en las fuentes de información".

La falta de información verificada en torno al presunto ataque estadounidense a Venezuela exacerbó aún más el problema. La ausencia de declaraciones oficiales de fuentes gubernamentales permitió que las imágenes generadas por IA llenaran el vacío de información, dando forma a la percepción pública antes de que se pudiera confirmar información precisa. Esto destaca la importancia de la alfabetización mediática y las habilidades de pensamiento crítico para navegar por el panorama digital.

Varias plataformas de redes sociales han comenzado a implementar medidas para detectar y marcar el contenido generado por IA, pero la tecnología está en constante evolución, lo que lo convierte en un continuo juego del gato y el ratón. Los investigadores están explorando métodos como el marcado de agua y el análisis forense para identificar imágenes sintéticas, pero estas técnicas no son infalibles. El incidente sirve como un crudo recordatorio de la necesidad de una investigación y un desarrollo continuos en la detección de la IA y la educación en alfabetización mediática para mitigar los riesgos de la desinformación. La situación sigue siendo fluida, con organizaciones de verificación de datos trabajando para desacreditar las imágenes falsas y proporcionar información precisa sobre la situación en Venezuela.

Discussion

Join the conversation

Be the first to comment