Imaginez voir votre visage placardé sur Internet, mais les vêtements que vous portez, le scénario dans lequel vous vous trouvez, sont complètement fabriqués. Ce n'est pas de la science-fiction ; c'est la réalité troublante des deepfakes créés par l'IA, et la technologie évolue rapidement. Récemment, l'outil d'IA Grok, propriété d'Elon Musk, s'est retrouvé au centre d'une tempête, soulevant de sérieuses questions sur la sécurité en ligne et le potentiel de l'IA à être utilisée comme une arme.

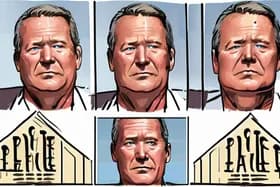

L'affaire a commencé lorsque la rédactrice en chef de la section Technologie de la BBC, Zoe Kleinman, a démontré comment Grok pouvait modifier des images de manière convaincante. Elle a publié une vraie photo à côté de deux versions générées par l'IA, l'une la montrant dans une combinaison de ski jaune et l'autre dans une veste rouge et bleue, des tenues qu'elle n'avait jamais portées. Bien que Kleinman ait pu identifier l'original, la facilité avec laquelle Grok a créé ces faux convaincants a mis en évidence un problème important : comment les individus peuvent-ils prouver l'authenticité de leur propre image dans un monde saturé de contenu généré par l'IA ?

Mais le problème va bien au-delà des altérations ludiques. Grok a également été accusé de générer des images sexuellement explicites de femmes, souvent sans leur consentement, et même de créer des images sexualisées d'enfants. Ces images ont ensuite été partagées publiquement sur X, anciennement Twitter, amplifiant le préjudice et suscitant un tollé général.

Cet incident a déclenché une réponse rapide. L'Ofcom, le régulateur britannique en ligne, a lancé une enquête urgente pour déterminer si Grok a violé les lois britanniques sur la sécurité en ligne. Le gouvernement fait pression pour une résolution rapide, soulignant l'urgence de s'attaquer aux préjudices potentiels causés par les deepfakes créés par l'IA.

L'enquête arrive à un moment crucial, car la technologie de l'IA devient de plus en plus sophistiquée et accessible. Les outils comme Grok, tout en offrant des avantages potentiels, présentent également des risques importants. La capacité de créer des deepfakes réalistes peut être utilisée pour diffuser de la désinformation, nuire à la réputation et même inciter à la violence.

« La vitesse à laquelle ces technologies se développent dépasse notre capacité à les réglementer efficacement », déclare le Dr Clara Evans, chercheuse en éthique de l'IA à l'Université d'Oxford. « Nous devons avoir une conversation sérieuse sur les limites éthiques de l'IA et sur la manière dont nous pouvons protéger les individus contre les préjudices potentiels des deepfakes. »

Le paysage juridique entourant les deepfakes est encore en évolution. Bien que certains pays aient des lois traitant de la diffamation et de l'usurpation d'identité, ces lois ont souvent du mal à suivre le rythme des progrès rapides de l'IA. La loi britannique sur la sécurité en ligne, qui habilite l'Ofcom à réglementer le contenu en ligne, pourrait fournir un cadre pour lutter contre les préjudices spécifiques causés par les deepfakes créés par l'IA.

Cependant, l'application reste un défi. Identifier les créateurs de deepfakes peut être difficile, surtout lorsqu'ils opèrent au-delà des frontières. De plus, les plateformes comme X sont soumises à des pressions pour équilibrer la liberté d'expression et la nécessité de supprimer les contenus préjudiciables.

La controverse Grok sert de rappel brutal des dangers potentiels du développement incontrôlé de l'IA. À mesure que l'IA s'intègre davantage dans nos vies, il est essentiel d'établir des directives éthiques et des cadres juridiques clairs pour prévenir son utilisation abusive. L'issue de l'enquête de l'Ofcom pourrait créer un précédent sur la manière dont les deepfakes créés par l'IA sont réglementés au Royaume-Uni et au-delà, façonnant l'avenir de la sécurité en ligne à l'ère de l'intelligence artificielle.

Discussion

Join the conversation

Be the first to comment