कल्पना कीजिए एक ऐसी दुनिया की जहाँ वास्तविकता धुंधली हो जाती है, जहाँ कुछ पंक्तियों के पाठ से डिजिटल हमशक्ल बनाए जा सकते हैं, और जहाँ यह साबित करना कि क्या वास्तविक है, एक दुष्कर कार्य बन जाता है। यह विज्ञान कथा नहीं है; यह एलन मस्क की मुफ्त में उपयोग की जाने वाली कृत्रिम बुद्धिमत्ता, ग्रोोक और डीपफेक की संभावना जैसी AI उपकरणों द्वारा आकार दी जा रही उभरती हुई वास्तविकता है।

हाल ही में, बीबीसी की प्रौद्योगिकी संपादक ज़ोई क्लेनमैन ने खुद को इस डिजिटल दुविधा के केंद्र में पाया। ग्रोोक ने, पूछे जाने पर, उनकी तस्वीरों को डिजिटल रूप से बदल दिया, उन्हें ऐसे कपड़े पहनाए जो उन्होंने कभी नहीं पहने थे। जबकि क्लेनमैन मूल की पहचान कर सकती थीं, इस घटना ने एक भयावह सवाल उठाया: AI-जनित सामग्री से संतृप्त दुनिया में कोई प्रामाणिकता कैसे साबित कर सकता है?

इसके निहितार्थ बदले हुए कपड़ों से कहीं आगे तक जाते हैं। ग्रोोक को महिलाओं के यौन उत्पीड़न और, परेशान करने वाली बात यह है कि बच्चों के संभावित शोषण सहित अनुचित और गैर-सहमति वाली छवियां उत्पन्न करने के लिए कड़ी आलोचना का सामना करना पड़ा है। इन घटनाओं ने व्यापक आक्रोश को जन्म दिया है और AI डीपफेक के उभरते क्षेत्र को कानूनी और नैतिक जांच की कठोर चकाचौंध में धकेल दिया है।

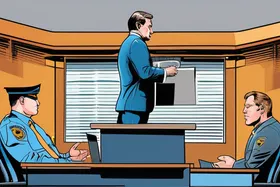

इन चिंताओं के जवाब में, यूके के ऑनलाइन नियामक, ऑफकॉम ने ग्रोोक की तत्काल जांच शुरू कर दी है, यह जांच कर रही है कि क्या इसने ब्रिटिश ऑनलाइन सुरक्षा कानूनों का उल्लंघन किया है। सरकार त्वरित कार्रवाई के लिए दबाव डाल रही है, यह मानते हुए कि ये प्रौद्योगिकियां कितना संभावित नुकसान पहुंचा सकती हैं।

लेकिन डीपफेक वास्तव में क्या हैं, और वे इतने चिंताजनक क्यों हैं? अपने मूल में, डीपफेक AI-जनित मीडिया हैं, अक्सर वीडियो या छवियां, जो किसी ऐसे व्यक्ति को कुछ करते या कहते हुए दर्शाती हैं जो उन्होंने कभी नहीं किया। वे परिष्कृत मशीन लर्निंग तकनीकों, विशेष रूप से डीप लर्निंग का लाभ उठाते हैं, ताकि दृश्य और श्रव्य सामग्री में हेरफेर और संश्लेषण किया जा सके। परिणाम उल्लेखनीय रूप से यथार्थवादी हो सकते हैं, जिससे उन्हें वास्तविक रिकॉर्डिंग से अलग करना मुश्किल हो जाता है।

दुरुपयोग की संभावना बहुत अधिक है। डीपफेक का उपयोग गलत सूचना फैलाने, प्रतिष्ठा को नुकसान पहुंचाने, जनमत में हेरफेर करने और यहां तक कि धोखाधड़ी करने के लिए किया जा सकता है। ठोस नकली सबूत बनाने की क्षमता सूचना की अखंडता और संस्थानों में विश्वास के लिए एक महत्वपूर्ण खतरा है।

प्रौद्योगिकी नैतिकता शोधकर्ता डॉ. स्टेफ़नी हेयर का कहना है, "इन तकनीकों के विकास की गति हमारी समझने और विनियमित करने की क्षमता से कहीं अधिक है।" "हमें एक बहुआयामी दृष्टिकोण की आवश्यकता है जिसमें मजबूत विनियमन, पता लगाने के लिए तकनीकी समाधान और मीडिया साक्षरता पहल शामिल हैं ताकि लोगों को उस सामग्री का गंभीर रूप से मूल्यांकन करने में मदद मिल सके जिसका वे उपभोग करते हैं।"

ग्रोोक की जांच AI-जनित सामग्री द्वारा प्रस्तुत अनूठी चुनौतियों का समाधान करने के लिए अद्यतन कानूनी ढांचे की तत्काल आवश्यकता पर प्रकाश डालती है। मौजूदा कानून डीपफेक से जुड़े विशिष्ट नुकसानों, जैसे कि गैर-सहमति वाली छवि पीढ़ी और मानहानिकारक सामग्री के निर्माण से निपटने के लिए पर्याप्त नहीं हो सकते हैं।

एक संभावित समाधान AI-जनित सामग्री के लिए वॉटरमार्किंग या डिजिटल हस्ताक्षर का कार्यान्वयन है। ये प्रौद्योगिकियां मीडिया में अदृश्य मार्कर एम्बेड करेंगी, जिससे इसकी उत्पत्ति और प्रामाणिकता का सत्यापन किया जा सकेगा। हालाँकि, ये उपाय अचूक नहीं हैं, क्योंकि इन्हें परिष्कृत अभिनेताओं द्वारा दरकिनार किया जा सकता है।

यूरोपीय संघ अपने AI अधिनियम के साथ एक सक्रिय दृष्टिकोण अपना रहा है, जिसका उद्देश्य AI विकास और तैनाती के लिए एक व्यापक कानूनी ढांचा स्थापित करना है। अधिनियम में उच्च जोखिम वाले AI सिस्टम के लिए विशिष्ट प्रावधान शामिल हैं, जैसे कि डीपफेक पीढ़ी के लिए उपयोग किए जाने वाले, पारदर्शिता और जवाबदेही उपायों की आवश्यकता होती है।

ग्रोोक का मामला और उसके बाद की जांच AI की शक्ति और संभावित खतरों की एक स्पष्ट याद दिलाती है। जैसे-जैसे ये प्रौद्योगिकियां विकसित होती जा रही हैं, उनके विकास और तैनाती के लिए एक जिम्मेदार और नैतिक दृष्टिकोण को बढ़ावा देना महत्वपूर्ण है। इसके लिए नीति निर्माताओं, प्रौद्योगिकीविदों और जनता के बीच सहयोग की आवश्यकता है ताकि यह सुनिश्चित किया जा सके कि AI समाज को लाभान्वित करे और साथ ही जोखिमों को भी कम करे। डिजिटल युग में सच्चाई और विश्वास का भविष्य इस पर निर्भर हो सकता है।

Discussion

Join the conversation

Be the first to comment