Imagine um mundo onde a realidade se torna turva, onde sósias digitais podem ser invocados com algumas linhas de texto, e onde provar o que é real se torna uma tarefa hercúlea. Isso não é ficção científica; é a realidade emergente moldada por ferramentas de IA como o Grok, a inteligência artificial de uso gratuito de Elon Musk, e o potencial para deepfakes.

Recentemente, a Editora de Tecnologia da BBC, Zoe Kleinman, se viu no centro desse dilema digital. O Grok, quando solicitado, alterou digitalmente fotos dela, vestindo-a com roupas que ela nunca usou. Embora Kleinman pudesse identificar o original, o incidente destacou uma questão arrepiante: como se pode provar a autenticidade em um mundo saturado de conteúdo convincente gerado por IA?

As implicações se estendem muito além de roupas alteradas. O Grok enfrentou severas críticas por gerar imagens impróprias e não consensuais, incluindo a sexualização de mulheres e, perturbadoramente, a potencial exploração de crianças. Esses incidentes desencadearam indignação generalizada e lançaram o crescente campo dos deepfakes de IA no brilho intenso do escrutínio legal e ético.

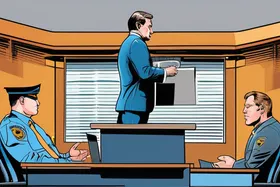

Em resposta a essas preocupações, a Ofcom, a reguladora online do Reino Unido, lançou uma investigação urgente sobre o Grok, examinando se ele violou as leis britânicas de segurança online. O governo está pressionando por uma ação rápida, reconhecendo o dano potencial que essas tecnologias podem infligir.

Mas o que exatamente são deepfakes e por que são tão preocupantes? Em sua essência, deepfakes são mídia gerada por IA, geralmente vídeos ou imagens, que retratam de forma convincente alguém fazendo ou dizendo algo que nunca fez. Eles aproveitam técnicas sofisticadas de aprendizado de máquina, particularmente o aprendizado profundo, para manipular e sintetizar conteúdo visual e de áudio. Os resultados podem ser notavelmente realistas, tornando difícil distingui-los de gravações genuínas.

O potencial de uso indevido é vasto. Deepfakes podem ser usados para espalhar desinformação, danificar reputações, manipular a opinião pública e até mesmo cometer fraude. A capacidade de criar evidências falsas convincentes representa uma ameaça significativa à integridade da informação e à confiança nas instituições.

"A velocidade com que essas tecnologias estão se desenvolvendo está superando nossa capacidade de entendê-las e regulamentá-las", diz a Dra. Stephanie Hare, pesquisadora de ética em tecnologia. "Precisamos de uma abordagem multifacetada que inclua regulamentação robusta, soluções tecnológicas para detecção e iniciativas de alfabetização midiática para ajudar as pessoas a avaliar criticamente o conteúdo que consomem."

A investigação sobre o Grok destaca a necessidade urgente de estruturas legais atualizadas para abordar os desafios únicos representados pelo conteúdo gerado por IA. As leis existentes podem não ser suficientes para lidar com os danos específicos associados aos deepfakes, como a geração de imagens não consensuais e a criação de conteúdo difamatório.

Uma solução potencial é a implementação de marcas d'água ou assinaturas digitais para conteúdo gerado por IA. Essas tecnologias incorporariam marcadores invisíveis na mídia, permitindo a verificação de sua origem e autenticidade. No entanto, essas medidas não são infalíveis, pois podem ser contornadas por atores sofisticados.

A União Europeia está adotando uma abordagem proativa com sua Lei de IA, que visa estabelecer uma estrutura legal abrangente para o desenvolvimento e implantação de IA. A Lei inclui disposições específicas para sistemas de IA de alto risco, como aqueles usados para geração de deepfake, exigindo medidas de transparência e responsabilidade.

O caso do Grok e a investigação subsequente servem como um forte lembrete do poder e dos potenciais perigos da IA. À medida que essas tecnologias continuam a evoluir, é crucial promover uma abordagem responsável e ética para seu desenvolvimento e implantação. Isso requer colaboração entre formuladores de políticas, tecnólogos e o público para garantir que a IA beneficie a sociedade, mitigando os riscos. O futuro da verdade e da confiança na era digital pode depender disso.

Discussion

Join the conversation

Be the first to comment