L'accord de licence stratégique de 20 milliards de dollars récemment conclu entre Nvidia et Groq signale un changement important dans le paysage de l'IA, suggérant que l'ère de la domination des GPU à usage général dans l'inférence de l'IA touche à sa fin. L'accord, annoncé début 2026, pointe vers un avenir d'architectures d'inférence désagrégées, où le silicium spécialisé répond aux exigences d'un contexte massif et d'un raisonnement instantané.

Selon FeaturedMatt Marshall, dans un article de janvier 2026, cette décision met en évidence une bataille sur quatre fronts pour l'avenir de la pile d'IA, devenant de plus en plus évidente pour les constructeurs d'entreprises. L'accord suggère que le GPU universel n'est plus la solution par défaut pour l'inférence de l'IA, en particulier pour les décideurs techniques axés sur la création d'applications d'IA et de pipelines de données.

Ce changement est motivé par l'importance croissante de l'inférence, la phase où les modèles d'IA entraînés sont déployés et utilisés pour faire des prédictions. Deloitte a rapporté que fin 2025, l'inférence avait dépassé l'entraînement en termes de revenus totaux des centres de données, marquant un tournant pour l'industrie. Cette augmentation des demandes d'inférence met à rude épreuve l'architecture GPU traditionnelle, ce qui nécessite des solutions spécialisées.

Le PDG de Nvidia, Jensen Huang, a investi une part importante des réserves de trésorerie de l'entreprise dans cet accord de licence pour faire face aux menaces existentielles qui pèsent sur la domination du marché de Nvidia, qui s'élèverait à 92 %. Cette décision est considérée comme une mesure proactive pour s'adapter aux demandes en constante évolution de l'inférence de l'IA et maintenir un avantage concurrentiel.

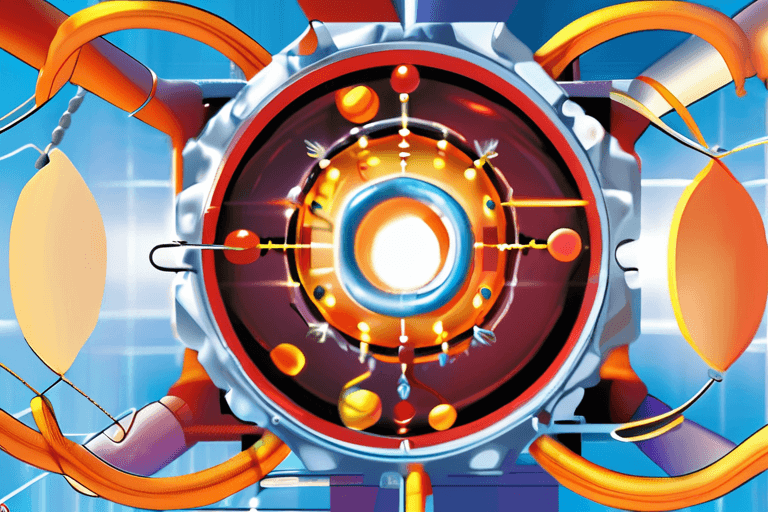

L'architecture d'inférence désagrégée implique de diviser le silicium en différents types, chacun étant optimisé pour des tâches spécifiques. Cette approche permet une plus grande efficacité et de meilleures performances dans la gestion des exigences complexes des applications d'IA modernes, qui nécessitent souvent à la fois une compréhension contextuelle étendue et une prise de décision rapide. Les détails de l'accord de licence et la nature exacte de la technologie faisant l'objet de la licence n'ont pas été divulgués, mais les analystes estiment qu'il s'agit de l'architecture de diffusion de tenseurs (TSA) de Groq, connue pour sa faible latence et ses hautes performances dans les charges de travail d'inférence.

Les implications de ce changement sont considérables et pourraient avoir un impact sur l'ensemble de l'écosystème de l'IA. Les entreprises qui construisent une infrastructure d'IA pourraient devoir réévaluer leurs choix de matériel, en envisageant des accélérateurs d'inférence spécialisés en plus des GPU à usage général. Cela pourrait entraîner une concurrence accrue entre les fournisseurs de matériel et stimuler l'innovation dans la conception de silicium pour l'IA. L'accord entre Nvidia et Groq devrait accélérer le développement et l'adoption d'architectures d'inférence désagrégées, façonnant ainsi l'avenir du déploiement de l'IA dans les années à venir.

Discussion

Join the conversation

Be the first to comment