Le 10 Downing Street a exprimé son approbation des informations selon lesquelles X, anciennement Twitter, prend des mesures pour lutter contre le problème des deepfakes générés par Grok, son modèle d'intelligence artificielle. Cette initiative intervient dans un contexte d'inquiétudes croissantes quant au potentiel d'utilisation abusive de contenus générés par l'IA pour diffuser de la désinformation et de la propagande.

Un porte-parole du Premier ministre a déclaré que le gouvernement saluait tous les efforts visant à atténuer les risques associés aux technologies d'IA avancées. "Nous avons clairement indiqué la nécessité d'une innovation responsable en matière d'IA, et nous sommes encouragés de voir des entreprises prendre des mesures proactives pour lutter contre les préjudices potentiels", a déclaré le porte-parole.

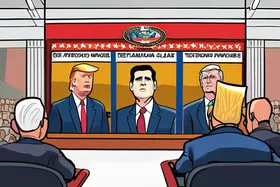

Les deepfakes, un mot-valise combinant "deep learning" (apprentissage profond) et "fake" (faux), sont des médias synthétiques dans lesquels une personne dans une image ou une vidéo existante est remplacée par l'apparence de quelqu'un d'autre. Grok, le modèle d'IA de X, est capable de générer des images et des vidéos réalistes, ce qui soulève des inquiétudes quant à son utilisation potentielle pour créer des représentations convaincantes mais fausses de personnes ou d'événements. La technologie repose sur des réseaux antagonistes génératifs (GAN), un type d'architecture d'apprentissage automatique où deux réseaux neuronaux s'affrontent : l'un génère du contenu faux et l'autre essaie de le distinguer du contenu réel, jusqu'à ce que le contenu généré devienne très réaliste.

X n'a pas encore publié de détails spécifiques sur les mesures qu'il met en œuvre pour lutter contre les deepfakes générés par Grok. Cependant, les analystes du secteur estiment que l'entreprise pourrait explorer des techniques telles que le filigrane de contenu généré par l'IA, le développement d'algorithmes pour détecter les deepfakes et la mise en œuvre de politiques de modération de contenu plus strictes. Le filigrane consiste à intégrer un marqueur subtil, souvent invisible, dans le contenu généré qui l'identifie comme étant généré par l'IA. Les algorithmes de détection analysent les images et les vidéos à la recherche de signes révélateurs de manipulation, tels que des incohérences dans l'éclairage, des mouvements faciaux non naturels ou des artefacts introduits par le processus GAN.

L'essor des deepfakes a suscité une inquiétude généralisée dans divers secteurs, notamment la politique, les médias et le divertissement. Les experts avertissent que les deepfakes pourraient être utilisés pour manipuler l'opinion publique, nuire à la réputation et même inciter à la violence. Le potentiel d'utilisation abusive est particulièrement aigu dans le contexte des élections, où les deepfakes pourraient être utilisés pour diffuser de fausses informations sur les candidats ou influencer la participation électorale.

Le gouvernement britannique a activement envisagé des cadres réglementaires pour l'IA, y compris des mesures pour lutter contre les risques associés aux deepfakes. L'Online Safety Act (loi sur la sécurité en ligne), qui est récemment entrée en vigueur, comprend des dispositions visant à lutter contre les contenus en ligne préjudiciables, y compris les deepfakes. Le gouvernement travaille également avec des partenaires internationaux pour élaborer des normes mondiales pour la gouvernance de l'IA.

Il reste à voir quelles mesures spécifiques X prendra pour lutter contre les deepfakes de Grok et quelle sera l'efficacité de ces mesures. L'entreprise devrait publier de plus amples informations dans les semaines à venir. L'efficacité de toute solution dépendra probablement de la sophistication des méthodes de détection et de la rapidité avec laquelle X pourra réagir aux menaces émergentes. Le développement et le déploiement continus des technologies d'IA nécessitent une vigilance et une adaptation constantes pour garder une longueur d'avance sur les utilisations abusives potentielles.

Discussion

Join the conversation

Be the first to comment