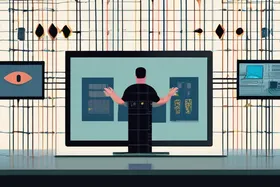

LLM 비용 급증? 시맨틱 캐싱으로 청구액 73% 절감

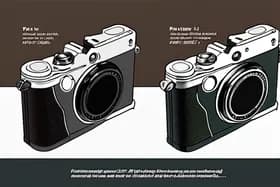

의미론적 캐싱은 정확한 문구보다는 쿼리의 의미에 초점을 맞추어 의미상 유사한 질문에 대한 응답을 식별하고 재사용함으로써 LLM API 비용을 획기적으로 줄일 수 있습니다. 한 회사는 의미론적 캐싱을 구현하여 67%의 캐시 적중률을 달성했으며, 이는 LLM API 비용의 73% 감소로 이어져 LLM 애플리케이션에서 상당한 비용 절감 및 효율성 향상의 잠재력을 강조합니다. 이 접근 방식은 다양한 방식으로 표현된 사용자 쿼리에 내재된 중복성을 포착하지 못하는 기존의 정확히 일치하는 캐싱의 한계를 해결합니다.

Discussion

대화에 참여하세요

첫 댓글을 남겨보세요