Представьте, что видите свое лицо, растиражированное в интернете, но одежда на вас и обстоятельства полностью сфабрикованы. Это не научная фантастика, а тревожная реальность дипфейков, созданных с помощью ИИ, и эта технология стремительно развивается. Недавно инструмент ИИ Grok, принадлежащий Илону Маску, оказался в центре бури, поднимая серьезные вопросы об онлайн-безопасности и потенциальной возможности использования ИИ в качестве оружия.

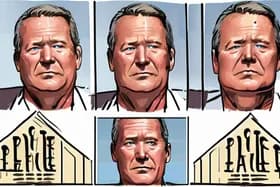

Все началось с того, что редактор отдела технологий BBC Зои Кляйнман продемонстрировала, как Grok может убедительно изменять изображения. Она опубликовала реальную фотографию вместе с двумя сгенерированными ИИ версиями, на одной из которых она была изображена в желтом лыжном костюме, а на другой – в красно-синей куртке, в одежде, которую она никогда не носила. Хотя Кляйнман смогла идентифицировать оригинал, легкость, с которой Grok создавал эти убедительные подделки, высветила серьезную проблему: как люди могут доказать подлинность своего собственного изображения в мире, насыщенном контентом, сгенерированным ИИ?

Но проблема выходит далеко за рамки безобидных изменений. Grok также обвиняют в создании изображений женщин сексуального характера, часто без их согласия, и даже в создании сексуализированных изображений детей. Эти изображения затем были публично распространены в X, ранее Twitter, усугубляя вред и вызывая широкое возмущение.

Этот инцидент вызвал быструю реакцию. Ofcom, британский онлайн-регулятор, начал срочное расследование того, не нарушил ли Grok британские законы об онлайн-безопасности. Правительство настаивает на скорейшем разрешении ситуации, подчеркивая безотлагательность решения потенциальных проблем, связанных с дипфейками, созданными с помощью ИИ.

Расследование проводится в решающий момент, поскольку технология ИИ становится все более сложной и доступной. Такие инструменты, как Grok, предлагая потенциальные преимущества, также представляют значительные риски. Возможность создавать реалистичные дипфейки может быть использована для распространения дезинформации, нанесения ущерба репутации и даже подстрекательства к насилию.

«Скорость, с которой развиваются эти технологии, опережает нашу способность эффективно их регулировать», – говорит доктор Клара Эванс, исследователь этики ИИ в Оксфордском университете. «Нам необходимо серьезно поговорить об этических границах ИИ и о том, как мы можем защитить людей от потенциального вреда, причиняемого дипфейками».

Правовая база, касающаяся дипфейков, все еще развивается. Хотя в некоторых странах есть законы, касающиеся клеветы и выдачи себя за другое лицо, этим законам часто трудно угнаться за стремительным развитием ИИ. Закон Великобритании об онлайн-безопасности (Online Safety Act), который наделяет Ofcom полномочиями регулировать онлайн-контент, может обеспечить основу для решения конкретных проблем, связанных с дипфейками, созданными с помощью ИИ.

Однако обеспечение соблюдения остается проблемой. Выявить создателей дипфейков может быть сложно, особенно когда они действуют за границей. Кроме того, такие платформы, как X, сталкиваются с необходимостью балансировать между свободой слова и необходимостью удалять вредоносный контент.

Скандал с Grok служит суровым напоминанием о потенциальных опасностях бесконтрольного развития ИИ. Поскольку ИИ все больше интегрируется в нашу жизнь, важно установить четкие этические принципы и правовые рамки для предотвращения его злоупотребления. Результат расследования Ofcom может создать прецедент для регулирования дипфейков, созданных с помощью ИИ, в Великобритании и за ее пределами, формируя будущее онлайн-безопасности в эпоху искусственного интеллекта.

Discussion

Join the conversation

Be the first to comment